Dalam pengembangan dan optimasi Large Language Models (LLM), terdapat tiga elemen krusial yang menentukan bagaimana model memproses dan memahami input teks: tokenizer, token, dan context window. Artikel ini akan menguraikan secara teknis bagaimana ketiga komponen tersebut bekerja, serta mengapa pemahaman terhadapnya penting dalam membangun solusi berbasis AI yang efisien dan scalable.

Apa Itu Tokenizer? Fungsi dan Cara Kerjanya

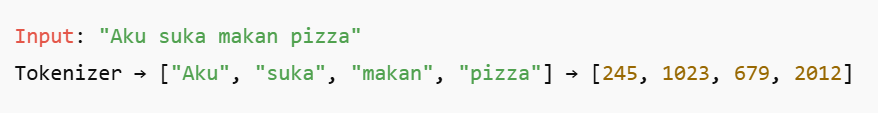

Tokenizer adalah komponen fundamental dalam arsitektur LLM yang bertugas memetakan teks alami ke dalam bentuk representasi numerik yang dapat diproses oleh model. Proses ini disebut tokenisasi, di mana teks dipecah menjadi unit-unit kecil yang disebut token.

Cara Kerja dan Pentingnya Tokenizer:

- Proses Encoding dan Decoding: Proses ini disebut encoding (teks ke token) dan decoding (token ke teks). Saat Anda mengirim prompt ke AI, tokenizer melakukan encoding. Ketika AI memberikan respons dalam bentuk angka (token), tokenizer mengubahnya kembali menjadi teks yang dapat Anda baca (decoding).

- Efisiensi dan Kualitas: Tokenizer yang baik dan efisien dapat memecah teks menjadi token yang lebih sedikit untuk jumlah kata yang sama. Misalnya, satu tokenizer mungkin memecah kata “Indonesia” menjadi satu token, sementara yang lain memecahnya menjadi Ind, one, sia. Tentu, tokenizer yang pertama lebih efisien karena menggunakan lebih sedikit token. Ini secara langsung memengaruhi kecepatan pemrosesan dan biaya.

- Waktu Pemrosesan & Biaya: Memahami cara kerja tokenizer membantu Anda menyadari bahwa panjang teks tidak selalu berkorelasi langsung dengan jumlah token. Tokenizer yang berbeda bisa menghasilkan jumlah token yang berbeda untuk teks yang sama.

- Pilihan Model AI: Saat memilih model AI, Anda juga secara tidak langsung memilih tokenizer yang digunakan. Tokenizer yang lebih efisien akan menghasilkan biaya yang lebih rendah untuk volume komunikasi yang tinggi.

Contoh:

Setiap token direpresentasikan sebagai angka indeks dari vocabulary model, lalu diubah menjadi vektor embedding. Vektor ini menjadi masukan ke dalam jaringan neural untuk diproses lebih lanjut.

Tokenizer modern seperti Byte Pair Encoding (BPE) atau Sentence Piece menggunakan pendekatan subword untuk menangani variasi bahasa dan struktur morfologis yang kompleks, memungkinkan efisiensi tokenisasi dalam berbagai bahasa.

Mengenal Token untuk Mengukur Efisiensi AI

Token adalah unit dasar teks yang digunakan oleh LLM untuk memahami, memproses, dan menghasilkan bahasa. Setiap interaksi dengan Large Language Model (LLM)—baik berupa prompt (input dari pengguna) maupun completion (output dari model)—diproses dan dihitung dalam satuan token.

Dalam konteks teknis, token bisa berupa kata, sub-kata, atau bahkan karakter tergantung pada algoritma tokenisasi yang digunakan (misalnya Byte Pair Encoding atau SentencePiece).

Token dan Cara Kerjanya:

- Token sebagai Fondasi: Token adalah fondasi dari semua interaksi yang Anda lakukan dengan AI. Ketika Anda mengetik “Halo, bagaimana kabarmu?”, model AI tidak melihat kalimat itu sebagai satu kesatuan. Ia melihatnya sebagai beberapa token terpisah.

- Mengapa Bukan Kata? Mengapa AI tidak bekerja dengan kata-kata? Karena jumlah kata dalam suatu bahasa bisa sangat besar dan terus bertambah, membuat model terlalu rumit untuk diproses. Dengan memecah kata menjadi token, model dapat bekerja dengan jumlah unit yang lebih kecil dan lebih efisien.

- Manajemen Biaya API: Biaya penggunaan API LLM seringkali dihitung berdasarkan jumlah token input (prompt Anda) dan output (respons AI), bukan jumlah kata. Memahami hal ini sangat penting untuk mengelola anggaran.

- Optimalisasi Prompt: Untuk menghemat biaya, Anda bisa melatih tim untuk membuat prompt yang ringkas, langsung, dan informatif. Setiap kata memiliki bobot biaya, dan setiap token dihitung.

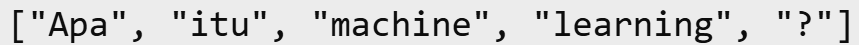

Contohnya:

Kalimat “Apa itu machine learning?” dapat dipecah menjadi beberapa token seperti

Setiap kata atau frasa ini akan dikonversi menjadi ID numerik yang digunakan oleh model untuk pemrosesan internal.

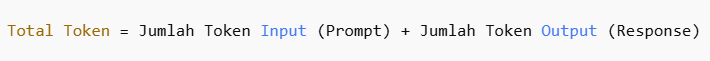

Total token dihitung sebagai:

Perhitungan ini bukan hanya relevan untuk tujuan teknis, tetapi juga berdampak langsung terhadap:

Biaya penggunaan API (karena banyak penyedia layanan seperti OpenAI mengenakan tarif per 1.000 token), performa inferensi, dan Batas maksimum context window dari model (yaitu jumlah maksimum token yang dapat diproses dalam satu sesi).

Apa Itu Context Window? Kapasitas Memori Jangka Pendek

Context Window adalah batas jumlah token yang dapat diproses model AI dalam satu kali interaksi atau percakapan. Ini adalah kapasitas maksimum input dan output yang dapat ditangani model dalam satu sesi. Ketika sebuah percakapan melebihi batas token yang ditentukan, AI akan mulai “melupakan” bagian-bagian awal dari percakapan tersebut.

Cara Kerja Context Window:

- Batasan Memori: Setiap model LLM memiliki context window yang berbeda-beda, mulai dari yang kecil (misalnya 4.096 token) hingga yang sangat besar (hingga 128.000 token atau lebih).

- Masalah “Lupa” AI: Jika prompt dan respons dalam satu percakapan melebihi batas token, model akan kehilangan konteks dari bagian awal percakapan. Ini dapat menyebabkan AI memberikan respons yang tidak relevan, tidak konsisten, atau bahkan “mengarang” fakta karena ia tidak lagi “mengingat” informasi penting yang Anda berikan sebelumnya.

- Kualitas Interaksi & Layanan Pelanggan: Untuk memastikan chatbot AI Anda memberikan respons yang relevan, penting untuk menjaga percakapan tetap dalam batas context window. Jika percakapan terlalu panjang dan terperinci, Anda mungkin perlu melatih tim untuk merangkumnya atau memulai percakapan baru dengan konteks yang ringkas di awal.

- Manajemen Biaya & Efisiensi: Panjang percakapan juga memengaruhi biaya. Percakapan yang lebih panjang membutuhkan lebih banyak token, yang secara langsung meningkatkan biaya API. Memantau panjang percakapan adalah kunci untuk mengelola anggaran.

Setelah context window terisi penuh, token paling awal akan ter-truncate, dan informasi lama bisa hilang. Itulah sebabnya model bisa menjawab:

“Maaf, saya tidak bisa mengakses pertanyaan awal karena keterbatasan context window.”

Contoh kapasitas context window:

- GPT-3: 4.096 token

- GPT-4 Turbo: hingga 128.000 token

Perlu dicatat bahwa context window besar membutuhkan lebih banyak compute dan memory, serta dapat memengaruhi latensi.

Mengapa Perhitungan Token Sangat Penting?

Dalam setiap interaksi dengan LLM—baik saat mengirim pertanyaan (prompt) maupun menerima jawaban (response)—jumlah token yang digunakan merupakan unit dasar yang dihitung oleh sistem. Token bukan hanya representasi teks secara internal, tetapi juga menjadi satuan utama dalam billing, resource allocation, dan performance tuning.

1. Optimalisasi Biaya

Layanan LLM komersial seperti OpenAI, Anthropic, Cohere, dan lainnya menetapkan harga berbasis jumlah token yang digunakan per permintaan. Artinya:

- Token Input + Token Output = Token Usage Total

- Model seperti GPT-4 Turbo dapat memiliki harga berbeda tergantung kapasitas context window dan mode penggunaan (prompt vs. completion).

- Dengan memahami jumlah token yang dikonsumsi, engineer dapat mengontrol biaya operasional API, terutama dalam skenario high-volume seperti chatbot, dokumentasi otomatis, atau data extraction pipeline.

Contoh: Jika biaya adalah $0.003 per 1.000 token, maka perbedaan antara 500 dan 3.000 token per query bisa sangat signifikan dalam skala besar.

2. Efisiensi Pemrosesan

Token memengaruhi waktu inferensi (latency) dan konsumsi resource. Di mana semakin banyak token, semakin panjang input sequence yang harus diproses oleh model transformer. Selain itu, proses attention dan feed-forward dalam arsitektur LLM bersifat kuadrat terhadap panjang input (O(n²) di beberapa kasus), sehingga efisiensi dapat turun drastis jika jumlah token tidak dikendalikan dan menimbulkan dampak sebagai berikut:

- Respons lebih lambat

- Konsumsi CPU/GPU dan memori meningkat

- Potensi rate limit atau timeouts jika digunakan dalam edge computing atau sistem realtime

3. Manajemen Input dan Batasan Context Window

Setiap model LLM memiliki batas maksimum context window—yaitu jumlah total token (input + output) yang dapat diproses sekaligus. Jika jumlah token melebihi batas ini:

- Token awal akan ter-truncate atau diabaikan (menghilangkan konteks penting)

- Output bisa menjadi tidak relevan atau salah interpretasi

Dengan mengelola token secara strategis, kita dapat:

- Memastikan bagian terpenting dari prompt tidak hilang

- Menerapkan teknik summarization atau pre-token filtering untuk input panjang

- Menjaga kualitas output sambil tetap dalam batas limitasi model

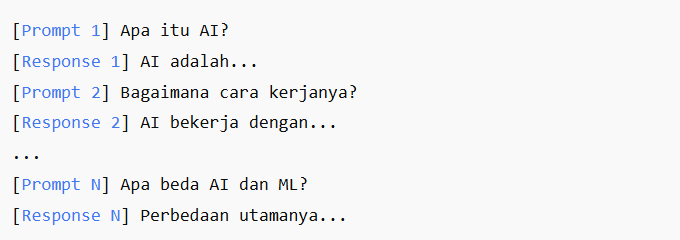

Contoh Skenario Token, Tokenizer, dan Context Window

Memahami sinergi antara Token, Tokenizer, dan Context Window sangat penting. Mari kita lihat bagaimana ketiganya bekerja sama dalam skenario layanan pelanggan di sebuah platform e-commerce.

1. Pelanggan Mengirim Pertanyaan

Seorang pelanggan memulai percakapan di live chat dengan pertanyaan: “Saya mau tanya soal pengiriman produk A. Udah seminggu kok belum sampai ya?” Pada saat yang sama, tim Anda harus bersiap untuk menanggapi permintaan pelanggan tersebut secara real-time.

2. Tokenizer Bekerja Mengubah Teks

Di belakang layar, Tokenizer langsung bekerja untuk memecah kalimat pelanggan menjadi unit-unit kecil yang disebut Token. Misalnya, kalimat tersebut dipecah menjadi token-token seperti Saya, mau, tanya, soal, pengiriman, produk, A, dan seterusnya. Proses ini mengubah bahasa manusia menjadi format numerik yang dapat dipahami oleh model AI, dengan total sekitar 15-20 token tergantung pada algoritma tokenizer yang digunakan.

3. Model AI Memproses dalam Context Window

Prompt yang telah diubah menjadi token ini, bersama dengan riwayat percakapan sebelumnya, akan masuk ke dalam Context Window model AI. Model kemudian menggunakan pengetahuannya untuk memahami bahwa ini adalah pertanyaan tentang status pengiriman. Berdasarkan informasi dalam context window dan kemampuannya, model dapat melakukan tindakan, seperti menggunakan tool yang terintegrasi (misalnya, ke sistem logistik) untuk mencari nomor pesanan pelanggan dan memberikan update status real-time.

4. Percakapan Berlanjut, Context Window Penuh

Jika percakapan terus berlanjut dengan detail yang sangat panjang, jumlah Token yang digunakan akan terus bertambah. Jika total token melebihi batas Context Window, model akan mulai “lupa” bahwa pertanyaan awal adalah tentang “produk A”. Ini dapat berujung pada respons yang tidak relevan atau tidak konsisten, dan mengharuskan agen manusia untuk mengambil alih dengan konteks yang tidak lengkap, yang bisa membuat pelanggan frustasi.

FAQ Teknis Seputar Tokenizer dan Context Window

Q: Apakah tokenizer mampu menangani struktur bahasa kompleks?

A: Ya. Untuk bahasa seperti Arab, Mandarin, atau bahasa agglutinatif, digunakan teknik subword tokenization agar kata-kata kompleks tetap dapat direpresentasikan dengan efisien.

Q: Apa dampaknya jika tokenizer salah memotong kata?

A: Kesalahan tokenisasi dapat menyebabkan distorsi makna, misalnya memotong “understand” menjadi “under” + “stand”. Namun, LLM modern menggunakan konteks kalimat untuk memperbaiki ambiguitas semacam ini.

Q: Apakah lebih banyak token berarti hasil AI lebih baik?

A: Tidak selalu. Meskipun konteks lebih luas bisa membantu, terlalu banyak token dapat menyebabkan output yang verbose atau kurang fokus. Optimasi adalah kuncinya.

Q: Bagaimana cara mengoptimasi penggunaan token?

A:

- Gunakan prompt yang spesifik dan ringkas.

- Hindari redundansi.

- Terapkan teknik few-shot dengan contoh yang efisien.

- Manfaatkan fitur memory atau conversational history jika tersedia.

Q: Apakah context window yang lebih besar berarti AI lebih “cerdas”?

A: Tidak otomatis. Walau context window besar memungkinkan pemrosesan konteks panjang, ada trade-off berupa peningkatan waktu proses dan konsumsi sumber daya.

Q: Apakah tokenizer menyimpan data pengguna?

A: Tidak. Tokenizer hanya berfungsi mentransformasikan teks ke token. Penyimpanan data tergantung pada kebijakan sistem backend AI, termasuk enkripsi, logging, dan anonymization.

Kesimpulan

Pemahaman menyeluruh terhadap cara kerja tokenizer, token, dan context window menjadi kunci dalam penerapan LLM yang efisien dan terukur. Ketiga elemen ini memengaruhi bagaimana teks diproses, sejauh mana konteks dapat dimanfaatkan, serta seberapa besar beban komputasi dan biaya yang ditimbulkan. Dalam praktiknya seperti, OpenAI Tokenizer Tool dapat digunakan untuk melihat bagaimana teks diubah menjadi token secara teknis, memberikan gambaran konkret mengenai struktur input dan output yang diolah oleh model.