Dalam beberapa tahun terakhir, teknologi AI telah berkembang dengan kecepatan luar biasa. Khususnya model bahasa besar (LLM) yang kini menjadi fondasi berbagai solusi teknologi modern. Sebagai tim AI, penting bagi kami untuk terus mengevaluasi berbagai model AI terkemuka agar bisa memberikan rekomendasi terbaik untuk kebutuhan bisnis. Artikel ini akan membahas perbandingan antara tiga model AI utama: OpenAI (ChatGPT), Claude (Anthropic), dan Gemini (Google DeepMind).

Apa itu OpenAI

OpenAI, dengan produk unggulannya ChatGPT, telah menjadi nama yang sangat familiar di dunia AI. Model ini dikenal dengan kemampuan pemrosesan bahasa alami yang sangat canggih dan serbaguna. ChatGPT mampu menghasilkan teks berkualitas tinggi untuk berbagai keperluan, dari penulisan kreatif hingga pemrograman kompleks.

Saat ini OpenAI menawarkan beberapa versi model, dengan yang terbaru adalah GPT-4o yang menunjukkan peningkatan signifikan dalam hal pemahaman konteks, penalaran, dan kemampuan mengikuti instruksi yang kompleks. Menariknya, OpenAI juga menawarkan versi “mini” yang lebih hemat biaya tapi tetap menyediakan performa yang mengesankan.

Apa itu Claude (Anthropic)

Claude dikembangkan oleh Anthropic dengan pendekatan yang menekankan pada keamanan dan etika. Model ini dibangun dengan filosofi “Constitutional AI” yang dirancang untuk menghasilkan respons yang bermanfaat, tidak berbahaya, dan jujur. Claude menonjol dalam kemampuannya menghasilkan output yang seimbang dan etis, serta mampu memproses dokumen yang sangat panjang.

Versi terbaru seperti Claude 3.5 Sonnet menunjukkan peningkatan kemampuan dalam memahami instruksi yang kompleks dan memberikan respons yang lebih bernuansa. Namun, seperti yang akan kita lihat dalam benchmark, Claude memiliki beberapa batasan dalam hal kecepatan dan biaya operasional.

Apa itu Gemini (Google DeepMind)

Gemini adalah model multimodal dari Google DeepMind yang mampu memproses input teks dan gambar secara bersamaan. Kemampuan multimodalnya memberikan keunggulan unik dalam aplikasi tertentu, dan integrasinya dengan ekosistem Google menjadikannya pilihan menarik untuk banyak use case.

Gemini memiliki kemampuan yang kompetitif dalam pemrosesan bahasa namun, seperti yang akan kita diskusikan, memiliki batasan signifikan dalam hal rate limit yang bisa menjadi hambatan untuk aplikasi skala besar.

Perbandingan Kemampuan Mode AI

Untuk memilih model AI yang paling sesuai dengan kebutuhan, penting untuk membandingkannya berdasarkan beberapa kriteria utama seperti kemampuan teknis, kemudahan integrasi, efisiensi biaya, serta fleksibilitas penggunaan. Analisis berikut akan menguraikan perbedaan masing-masing model—OpenAI, Claude, dan Gemini—berdasarkan kriteria-kriteria tersebut untuk memberikan gambaran yang lebih menyeluruh dalam pengambilan keputusan.

1. Kemampuan Teknis AI

Kemampuan teknis mencakup performa model dalam memahami konteks, menjawab dengan akurat, serta menangani berbagai jenis tugas seperti reasoning, summarization, atau code generation. Setiap model—OpenAI, Claude, dan Gemini—memiliki pendekatan dan kekuatan teknis yang berbeda, tergantung pada arsitektur, jumlah parameter, serta data pelatihan yang digunakan.

2. Integrasi AI

Ketiga model—OpenAI, Claude, dan Gemini—telah dirancang untuk dapat diintegrasikan ke dalam berbagai aplikasi melalui dukungan library dan API resmi. Hal ini memudahkan developer untuk mengakses kemampuan model secara langsung dari dalam sistem yang mereka bangun, tanpa harus mengelola infrastruktur model secara mandiri.

Dengan ketersediaan SDK, REST API, serta dukungan di platform cloud seperti Azure dan Google Cloud Vertex AI, proses integrasi menjadi lebih fleksibel, scalable, dan dapat disesuaikan dengan berbagai kebutuhan teknis organisasi.

- OpenAI: integrasi dengan Library OpenAI dan Azure OpenAI. kita dapat menggunakan library OpenAI untuk mengakses model-model mereka. Selain itu, Azure menyediakan layanan Azure OpenAI yang memungkinkan integrasi model OpenAI melalui infrastruktur Azure, memberikan fleksibilitas tambahan dalam pengembangan aplikasi.

- Claude: Untuk mengintegrasikan model Claude ke dalam aplikasi, kita dapat memanfaatkan API yang disediakan oleh Anthropic atau menggunakan Google Cloud Vertex AI dari Google.

- Gemini: Integrasi melalui Google Cloud Vertex AI, model Gemini tersedia melalui platform Vertex AI milik Google Cloud. Dengan menggunakan SDK yang disediakan, seperti Vertex AI SDK untuk Python, Anda dapat mengakses dan memanfaatkan kemampuan model Gemini dalam aplikasi.

3. Pemrosesan Multimodal

Dalam hal kemampuan multimodal, ketiga model telah menunjukkan kemajuan signifikan, meskipun dengan tingkat kemampuan yang berbeda.

- Gemini memiliki keunggulan bawaan dalam mengolah input lintas format, terutama teks dan gambar, secara bersamaan dalam satu konteks. Ini menjadikannya sangat efektif untuk aplikasi yang memerlukan pemahaman visual, seperti analisis dokumen bergambar, UI automation, atau pencarian berbasis konten visual.

- OpenAI GPT-4o juga menghadirkan kemampuan multimodal yang kuat, mampu menangani input teks, gambar, dan bahkan audio secara terintegrasi. Keunggulan GPT-4o terletak pada kemampuannya dalam mempertahankan konteks lintas modal secara konsisten, yang membuka potensi untuk use case seperti asisten suara cerdas dan sistem rekomendasi berbasis gambar.

- Sementara itu, Claude, dalam versi terbarunya, telah mulai mengadopsi fitur multimodal. Meskipun kemampuannya masih berada sedikit di bawah Gemini dan GPT-4o dalam hal kompleksitas dan akurasi pengolahan input multimodal, perkembangan ini menunjukkan arah yang menjanjikan dalam roadmap pengembangan Claude.

Secara keseluruhan, Gemini dan GPT-4o saat ini memimpin dalam hal pemrosesan multimodal, namun kompetisi di ranah ini masih terus berkembang seiring pembaruan model.

4. Efisiensi dan Biaya Antar Model AI

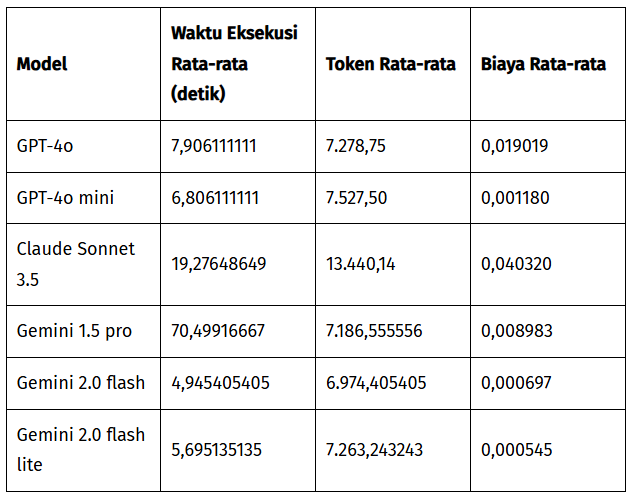

Berdasarkan hasil pengujian performa dan analisis internal, terdapat perbedaan yang cukup signifikan dalam hal efisiensi dan biaya di antara model-model yang dibandingkan. Temuan ini memberikan gambaran praktis mengenai trade-off antara performa dan harga pada masing-masing model dalam konteks penggunaan dunia nyata.

Biaya Penggunaan:

- GPT-4o mini menunjukkan biaya rendah dengan performa yang masih sangat kompetitif.

- GPT-4o menawarkan keseimbangan baik antara performa dan biaya.

- Claude Sonnet 3.5 ternyata paling mahal dengan biaya sekitar 62% lebih tinggi dibanding GPT-4o.

- Gemini 1.5 pro menawarkan harga yang kompetitif, tapi dibatasi oleh masalah rate limit.

- Gemini 2.0 flash lite menawarkan harga yang lebih rendah dari GPT-4o mini

Waktu Eksekusi:

- Gemini 2.0 Flash lite menunjukkan waktu eksekusi tercepat

- Gemini 1.5 Pro menunjukkan waktu eksekusi terlama karena masalah ratelimit

- Claude Sonnet 3.5 memiliki waktu eksekusi yang lebih lambat dibanding model OpenAI.

Studi Kasus dan Pengalaman Pengguna

Untuk memahami bagaimana masing-masing model berfungsi dalam praktik, kami meninjau sejumlah studi kasus dan pengalaman dari pengguna yang telah mengimplementasikan OpenAI, Claude, dan Gemini dalam berbagai skenario nyata.

Perspektif ini memberikan wawasan tambahan tentang kekuatan, keterbatasan, serta respons pengguna terhadap performa, integrasi, dan manfaat yang dirasakan dalam konteks operasional mereka.

Tim AI kami telah melakukan benchmark komprehensif pada ketiga model ini, dengan fokus pada dua kasus penggunaan utama

1. Benchmark LLM untuk RAG (Retrieval-Augmented Generation)

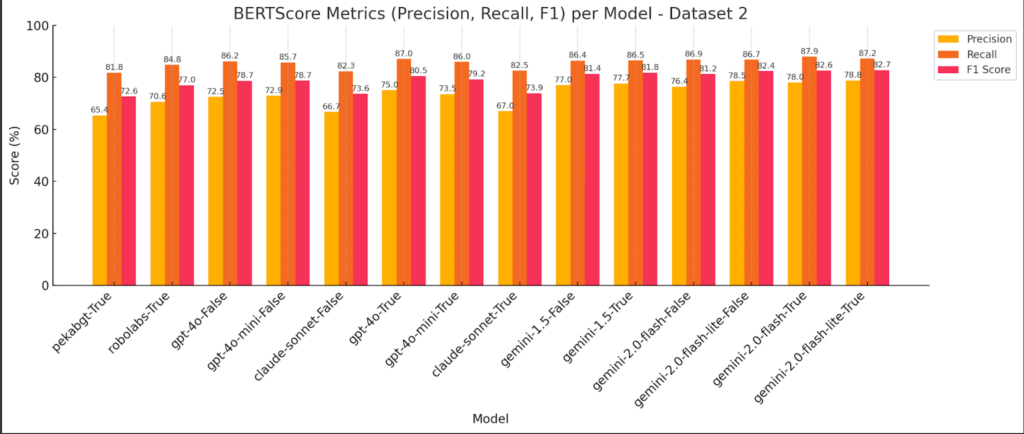

Kami menguji performa model dalam menjawab pertanyaan berdasarkan dokumen yang diberikan (dokumen SDR dan Samsung) menggunakan metode QAG (Question-Answering with Generated Evidence) dan LLM as Judge.

Pengujian dari single document, untuk score Precision, Recall dan F1

Penilaian jawaban dengan relevansi konteks dengan metode LLM as Judge pada single dokumen.

Penilaian jawaban dengan relevansi konteks dengan metode LLM as Judge pada single dokumen.

Hasilnya menunjukkan:

- Secara umum, seluruh model mengalami penurunan performa di dokumen Samsung (karena konten dan pertanyaan lebih beragam).

- GPT-4o mini pun tampil lumayan stabil dengan biaya jauh lebih rendah, walau belum tentu lebih unggul di LLM as Judge ketimbang GPT‑4o

- Gemini 2.0 Flash menunjukkan potensi yang baik dengan skor yang bagus tetapi tidak cukup untuk mengalahkan 4o pada kualitas jawaban (berdasarkan LLM as judge) tetapi skor BERT mereka lebih baik dari 4o tetapi tidak signifikan

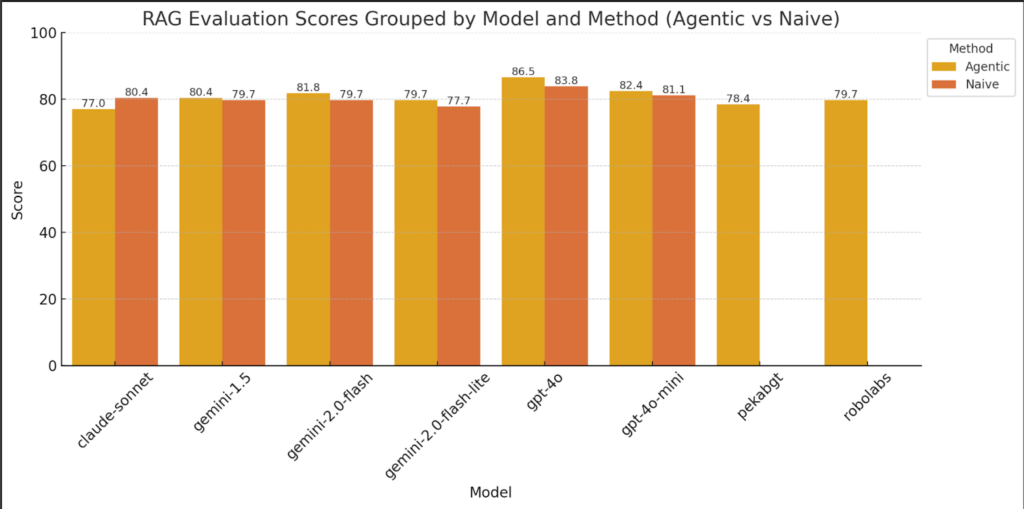

2. Agentic RAG

Kami juga mengevaluasi pendekatan agentic dalam skenario Retrieval-Augmented Generation (RAG), di mana model tidak hanya merespons permintaan secara langsung, tetapi juga diberi kemampuan untuk melakukan refleksi, mengevaluasi jawabannya sendiri, dan menyempurnakan respons secara iteratif.

Pendekatan ini dirancang untuk meniru proses berpikir berlapis, sehingga menghasilkan jawaban yang lebih akurat, relevan, dan kontekstual—terutama dalam kasus yang kompleks atau memerlukan reasoning tingkat tinggi.

Temuan menarik kami untuk model OpenAI:

- Pendekatan agentic meningkatkan akurasi respons, tetapi tidak signifikan dibandingkan dengan peningkatan waktu dan biaya.

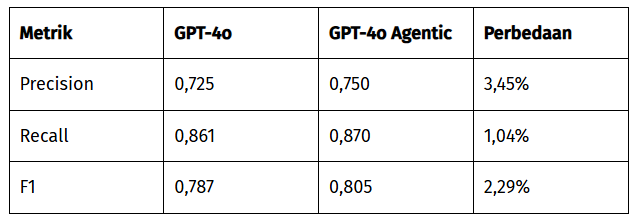

- Untuk GPT-4o, peningkatan skor F1 hanya 2,29% tetapi dengan peningkatan waktu eksekusi 2-3x lipat dan peningkatan biaya 1,1-1,5x lipat.

Contoh peningkatan untuk GPT-4o:

Kesimpulan

Dari hasil benchmark yang kami lakukan, penggunaan pendekatan agentic—di mana model diberi kemampuan untuk melakukan refleksi dan iterasi terhadap jawabannya sendiri—terbukti meningkatkan akurasi, namun juga berdampak signifikan pada biaya dan waktu eksekusi, dengan peningkatan berkisar antara 2× hingga 6,5× dibanding pendekatan langsung (non-agentic).

Dalam konteks agentic workflow, berikut peringkat model berdasarkan tiga kriteria utama:

Akurasi:

- GPT-4o

- Gemini 2.0 Flash / Flash Lite

Waktu Respons:

1–2 Gemini 2.0 Flash dan Flash Lite

Biaya Eksekusi:

- Gemini 2.0 Flash Lite

- Gemini 2.0 Flash

Meskipun GPT-4o unggul dari segi akurasi (baik dalam metrik BERT Score maupun LLM-as-a-Judge), keunggulan tersebut dalam banyak kasus hanya terpaut beberapa poin persentase dalam skor F1. Sementara itu, Gemini 2.0 Flash Lite menampilkan keseimbangan yang sangat baik antara akurasi, kecepatan, dan efisiensi biaya—menjadikannya pilihan terbaik dalam hal cost-performance.